Traitement et Reconnaissance Robuste de Textes dans les Images ou des Vidéos numériques :

Objectifs scientifiques

Traitement et Reconnaissance Robuste de Textes dans les Images ou des Vidéos numériques : Objectifs scientifiques |

|

Ce projet a pour objectif de développer de nouvelles méthodes pour restaurer les images très dégradées de textes afin de pouvoir les reconnaître par OCR (Optical Character Recognition).

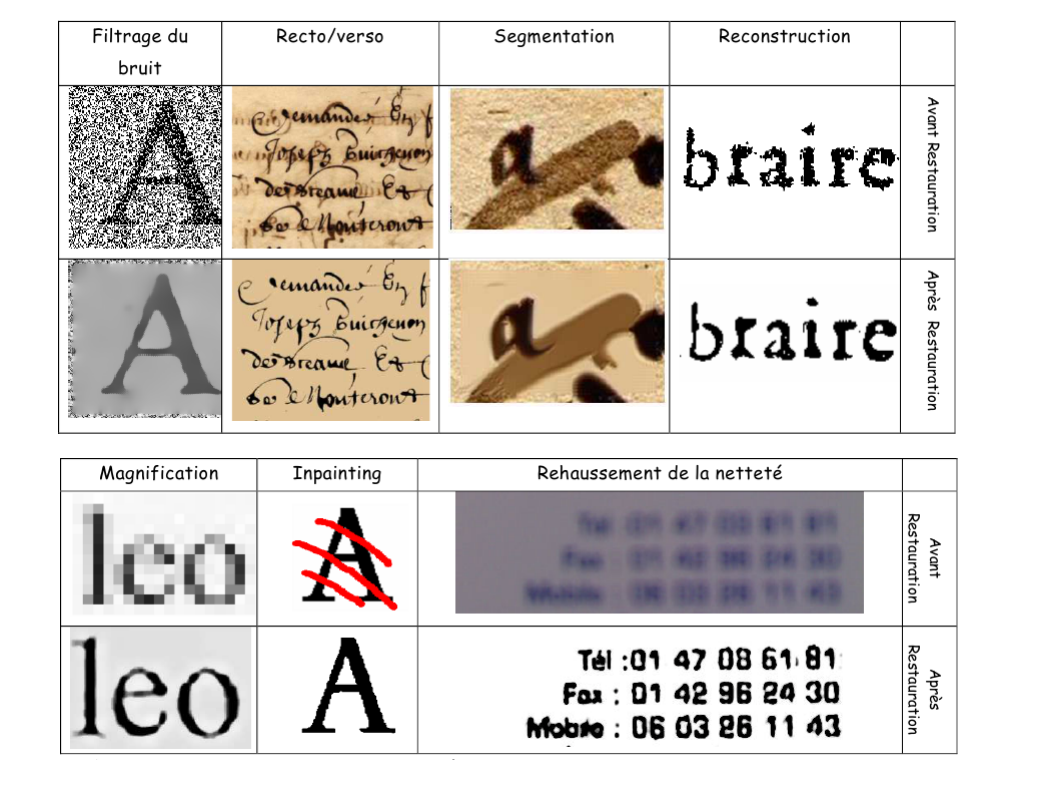

Le projet s'applique d'abord aux images de documents dans le cadre des grands projets de numérisation actuellement en cours dans toutes les grandes bibliothèques nationales du monde ainsi que les documents numérisés dans les archives des administrations et des grandes entreprises. Les images de documents du patrimoine font apparaître de nombreuses dégradations qui sont soit physiques dues soit au vieillissement du support, soit numériques causées par le processus de numérisation. Les dégradations physiques causées par le vieillissement du support sont nombreuses comme les pliures, les trous, le vieillissement des encres et du support papier, la transparence du papier qui laisse le verso apparaître sur le recto, les taches et les dégradations physiques d'origine humaine comme les annotations et les tampons. Les dégradations dues au processus de numérisation apparaissent sous des formes diverses comme le bruit dans les images, les déformations géométriques comme la courbure et l'inclinaison, le manque de netteté, les aberrations chromatiques, les problèmes de perte d'information à cause d'un manque de résolution spatial et couleur.

Le projet concerne aussi les images et vidéos issues de terminaux mobiles (appareil photo numérique, photophone, webcam entre autres), contenant du texte et dont le nombre ne cesse de croître.

Ces images et vidéos prises par des terminaux mobiles sont généralement mal cadrées, mal exposées, souvent floues et présentent des effets de perspectives. De plus les textes sont soit imprimés sur des fonds texturés ou colorés soit mélangés à une scène complexe (« in the wild »). En outre, un autre problème majeur est le temps de traitement des différents algorithmes proposés, répondant à la contrainte de l'informatique embarquée.

En ce qui concerne la reconnaissance des caracètres, le texte contenu dans une image ou une vidéo est un élément sémantique très important permettant d'en caractériser fortement le contenu, de les indexer pour une recherche par mots clés textuels. Le développement de systèmes OCR a reçu beaucoup d'attention depuis de nombreuses années. De multiples solutions commerciales efficaces existent, mais s'appliquent pour la plupart à des documents papier scannés, dont le texte apparaît généralement sur un fond relativement uniforme, dans des conditions normalisées. Les méthodes actuelles de lecture optique fonctionnent à 99,8% sur des images de bonne qualité avec une résolution suffisante en association avec un dictionnaire. Sans le recours du dictionnaire, les performances actuelles des OCRs sont très faibles pour les documents anciens dégradés ou les images et vidéos issues de terminaux portables, contenant du texte, dont les contenus sont a priori inconnus. Dans le cas des images numériques ou des vidéos obtenues par photophones, le problème est nettement plus complexe et nécessite un effort de recherche important. Le texte présent (texte de scène) peut apparaître dans des conditions variées sur des fonds variables et complexes. De plus, la qualité des vidéos ou des images est variable, et de nombreux facteurs (illumination, perspective, bruits, résolution, mouvement, artefacts de compression, etc..) affectent l'apparence du texte, rendant sa segmentation imprécise et donc sa reconnaissance difficile.

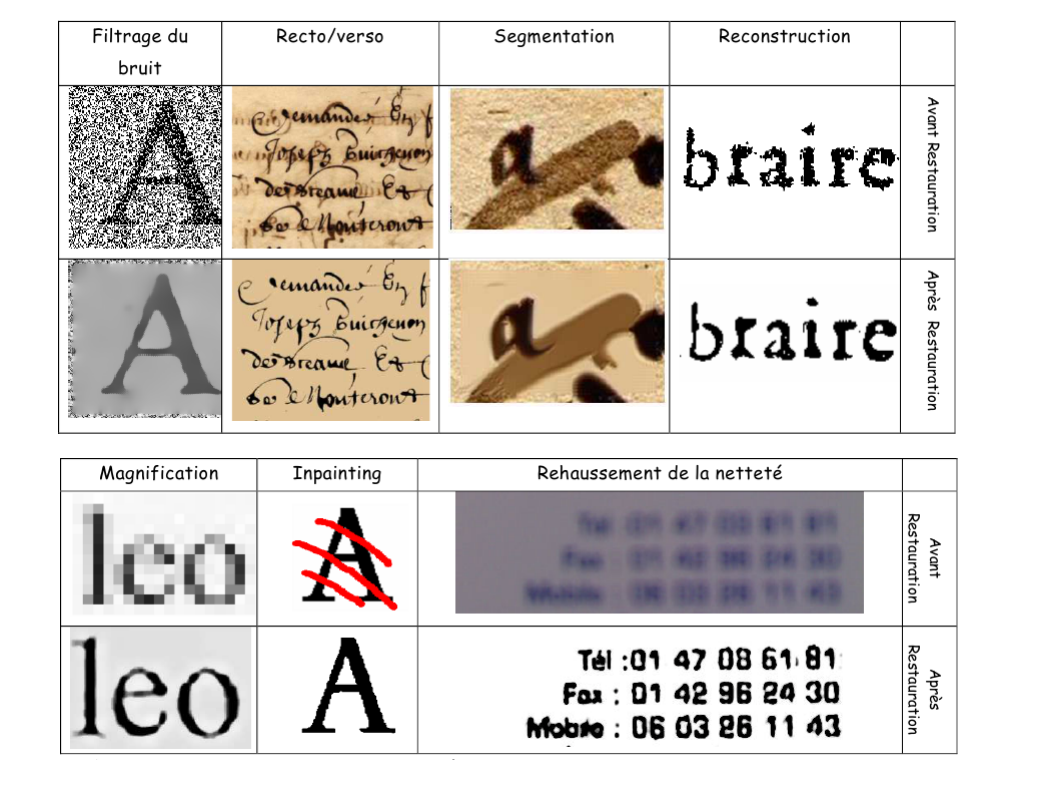

Ce projet de recherche propose de considérer les images numériques de textes comme une solution d'un modèle régie par des Equations aux Dérivées Partielles, et d'adapter les algorithmes mathématiques à la problématique. Les EDPs offre un cadre mathématique unique qui permet de formaliser tous les traitements sous la forme d'une écriture simplifiée. Ce modèle mathématique est particulièrement bien adapté aux images de textes qui possèdent des dérivées bien définies autour des traits. Le lien avec l'espace multi-échelle permet de traiter les images en faible résolution au niveau sub-pixelaire. Cette propriété permet de réduire le bruit en conservant les structures fines, de magnifier les images en retrouvant l'information sous-jacente d'une image pauvre en résolution, d'utiliser la morphologie continue qui permet d'éroder ou de dilater une forme d'une fraction infime de pixel dans le domaine continue. Les EDPs permettent donc de s'affranchir des problèmes des espaces discrets et de traiter les images dans le domaine continu où les mathématiques n'ont plus de limites.

Nous proposons de combiner la segmentation colorimétrique avec les EDP de diffusion anisotropique pour la segmentation des textes sur des fonds texturés ou colorés ou bien à la séparation aveugle (sans utiliser l'image du verso) entre le recto et le verso. Nous proposons d'étudier les rapports entre les méthodes non locales et les approches locales à base de diffusion par EDP pour à la fois restaurer les formes des caractères et magnifier les images en basse résolution. Contrairement au filtrage non local qui exploite la ressemblance entre les différentes parties de l'image, les méthodes de filtrage par EDP utilise essentiellement l'information locale sub-pixelaire. Ces deux approches sont donc complémentaires et méritent d'être comparées et combinées dans un cadre commun. Nous proposons d'étudier plus précisément les bénéfices des approches non locales vs locales par EDP dans le cadre des images de documents. L'approche non locale apportera l'information locale manquante et la diffusion anisotropique régularisera progressivement l'information locale en cours de restauration en fonction de la structure des isophotes. La combinaison d'un filtrage non local et local devrait permettre de réaliser des réparations plus importantes sur des images encore plus dégradées.

Pour les images et vidéos de textes issus de terminaux mobiles, nous proposons de corriger les déformations géométriques (perspectives, inclinaison, courbure) dues au mauvais cadrage des images réalisées avec ces terminaux mobiles tenus à la main. De même les défauts d'illumination devront être réduits par une mise à plat et les aberrations chromatiques autour des caractères supprimés. Comme ces terminaux prennent des images fixes à partir du flux vidéo continu affiché à l'utilisateur, nous proposons d'utiliser plusieurs images similaires de la même scène sur au moins 1 secondes pour reconstruire une image nettoyée du bruit, magnifiée en résolution et rehaussée en netteté à partir d'une vingtaine d'images. Nous étudierons un filtre non local spatio-temporel qui utilise des parties similaires dans l'image elle-même et dans les autres images décalées temporellement dans le flux vidéo. Ce filtre non local sera couplé par avec des filtres de restauration par diffusion anisotropique spatiotemporel (2D+t) pour préserver les structures fines des formes complexes des lettres.

La première phase du projet est de formaliser et de valider un modèle mathématique (E.D.P) fidèle à la réalité qui prend en compte la majorité des contraintes du problème. Une première approche de ce modèle a été proposée par la société RealEyes3D (qui a déposé le bilan en juillet 2010). Ce premier essai fut un succès. En effet, plus de 100 millions de téléphones portables ont été vendus dans le monde, intégrant nos applications d'envoi de messages "manuscrits" (Digitizer©, w-Postcard©, Clipper©, MagicWanda©). Notre ambition est de reprendre cette étude et d'en améliorer dans un premier temps les aspects de modélisation. Ensuite à partir de cette modélisation, une fois établie, il s'agira de développer des algorithmes permettant de résoudre les équations qui en découlent. Pour cela une étude théorique s'impose en termes d'existence, d'unicité, de régularité et de comportement de la solution. Ensuite nous aborderons une analyse numérique qui définira l'algorithme et fournira une approximation de la solution en fonction de la consistance, la stabilité du schéma numérique et la complexité de l'algorithme, répondant à notre contrainte de l'informatique embarquée : sa rapidité. La tâche suivante est l'implémentation sur ordinateur avec la vérification du programme résultant sur une grande gamme/base d'images, et enfin, une étape de mis en adéquation de cet algorithme avec les systèmes d'exploitation et les moyens de calculs des téléphones mobiles. L'idée est de reprendre le concept du réhaussement du texte dans une image acquise dans des conditions d'illumination variable par de nouvelles techniques d'estimations du "fond" (diffusion isotrope et anisotrope). Enfin l'implémentation optimisée des EDPs permet d'obtenir des traitements quasi-temps réel (moins de 2 secondes) adapté à la faible puissance de calculs des terminaux portables comme les téléphones mobiles. Les qualités de rapidité, fiabilité et de souplesse des méthodes par EDP, permettent l'embarquement efficace des logiciels développés sur les téléphones portables. Enfin nous étudierons plus théoriquement les EDP locaux/non locaux ainsi que les EDP spatiales/spatio-temporelles pour à la fois la segmentation du fond, la séparation aveugle entre recto/verso, la magnification des images en sous résolution, le réhaussement de la netteté des images floues, le filtrage du bruit, la reconstruction de parties manquantes par Inpainting, la réduction des dégradations des artefacts de la compression Jpeg et la restauration des formes dégradées.

La séparation aveugle de sources (SAS) est une technique du traitement statistique du signal qui consiste à restituer des signaux inobservables (appelés signaux sources) à partir de signaux observés, mélanges de ceux-ci. Les signaux sources et les coefficients du modèle de mélange sont inconnus. L'objectif de la SAS est d'estimer les sources à partir des signaux mélange observés. Il s'agit donc d'un problème fortement mal posé. Le mélange est généralement supposé être linéaire, instantané ou convolutif. Si les signaux sources sont supposés indépendants et qu'au plus un des signaux sources est gaussien, une solution à ce problème existe à une permutation et un facteur d'échelle près ou à un opérateur filtrant près. La solution est alors approchée via la minimisation d'un estimateur d'un critère de dépendance des signaux. Comme la solution est déterminée à un facteur d'échelle près (ou un un opérateur filtrant près) le critère de dépendance est combiné avec un terme de pénalisation permettant de s'affranchir de cette indétermination. Dans le domaine de la séparation aveugle entre le recto et le verso d'un document quand celui-ci apparaît en transparence, de nombreux travaux ont été mené avec des approches théoriques très différentes comme la classification non linéaire des couleurs , les MRF, les EDP et enfin la séparation aveugle de sources. Le LIRIS grâce aux nombreux projets de numérisation auxquels le laboratoire a participé.

Les réseaux de neurones traditionnels, notamment les perceptrons multicouches (MLP) permettent d'approximer des fonctions non-linéaires complexes, à partir d'exemples via des algorithmes d'apprentissage, généralement des algorithmes de descente du gradient, comme l'algorithme bien connu de la rétro-propagation du gradient. Dans le domaine de l'analyse d'images et de la vision par ordinateur, les MLPs sont généralement utilisés pour classer des signatures extraites en amont par un algorithme d'extraction de caractéristiques, souvent choisi de manière empirique. Pour apprendre à classer les vecteurs caractéristiques tout en apprenant à extraire les caractéristiques les plus discriminantes, une solution idéale peut consister à appliquer les MLPs directement sur les pixels. Malheureusement, les données images à classer étant de très grande dimension (400, par exemple, pour une imagette de 20x20 pixels), le nombre de paramètres à apprendre (les coefficients synaptiques) dans une architecture complètement connectée (où chaque neurone est connecté à l'ensemble des pixels de la couche d'entrée) devient rapidement très supérieur au nombre d'exemples disponibles. Cela conduit classiquement à du sur-apprentissage. Les réseaux de neurones à convolution (Convolutional Neural Networks, CNN), modèles bio-inspirés, ont été proposés pour résoudre ces problèmes en combinant trois principes architecturaux : des champs réceptifs locaux qui permettent de détecter des caractéristiques locales ; le partage des poids entre champs réceptifs qui permettent de répliquer la recherche de ces caractéristiques ; et un mécanisme de sous-échantillonnage permettant de réduire la sensibilité aux variations de faible amplitude en translation, rotation et échelle ou aux faibles distorsions. Dans le cadre de ce projet, nous étendrons les approches développées spécifiquement pour la reconnaissance de textes incrustés dans les vidéos au cas du texte de scènes dans des images et vidéos, prises en mobilité dans des conditions non contrôlées (illumination, perspective) et dont les polices et styles peuvent être très variables. Les méthodes actuelles dédiées à la reconnaissance spécifique de texte vidéo reposent pour la plupart sur des techniques fortement dépendantes d'une segmentation réussie (mais en général très difficile) des caractères. Les approches que nous envisageons viseront à une classification des caractères sans prétraitement local (binarisation, segmentation..) mais en prenant en compte directement les pixels de l'imagette englobant chaque caractère. Des méthodes d'apprentissage statistiques et neuronales seront développées dans ce sens, permettant la prise en compte robuste de l'ensemble des facteurs de bruit dont la forte variabilité du fond. En fonction de l'application (type de document), nous adjoindrons à notre schéma d'apprentissage automatique un mode de supervision reposant sur des modèles de langages, des dictionnaires (nom propres par exemple) ou plus généralement des ontologies spécifiques à des domaines de connaissances. L'ensemble des modules de reconnaissance se verront pilotés par cette connaissance pour lever les ambiguïtés liées à une reconnaissance locale lettre à lettre.

|

|